Add files via upload

This commit is contained in:

parent

d1303ad5fa

commit

8629ff8df9

|

|

@ -0,0 +1,657 @@

|

||||||

|

# 1 文件自动化处理

|

||||||

|

|

||||||

|

## 1.1 读写文件

|

||||||

|

我们知道,程序运行时,可以用变量来保存运算结果,但如果希望程序运行关闭后,依然可以查看运行后的结果,就需要将数据保存到文件中。简单点,你可以将文件内容理解为一个字符串值,大小可能有几个GB。本节将学习,如何使用python在硬盘上创建、读取和保存文件。

|

||||||

|

|

||||||

|

## 1.1.1 文件与文件路径

|

||||||

|

文件的两个属性:“路径”和“文件名”,路径指明文件在计算机上的位置,文件名是指该位置的文件的名称。比如,我的电脑上,有个名字为Datawhale - 开源发展理论研究.pdf的文件,它的路径在D:\Datawhale。在windows中,路径中的D:\部分是“根文件夹”,Datawhale是文件夹名。注:Windows中文件夹名和文件名不区分大小写的。

|

||||||

|

|

||||||

|

在windows上,路径书写是使用倒斜杠'\'作为文件夹之间的分隔符,而在OS X和Linux上,是使用正斜杠'/'作为它们的路径分隔符。通常我们用`os.path.join()`函数来创建文件名称字符串。

|

||||||

|

|

||||||

|

```python

|

||||||

|

import os

|

||||||

|

os.path.join('Datawhale','docu')

|

||||||

|

```

|

||||||

|

|

||||||

|

我们可以看到返回的是('Datawhale\\\docu'),有两个斜杠,这是因为有一个斜杠是用来转义的,在OS X或Linux上调用这个函数,这个字符串就会是'Datawhale/docu'。

|

||||||

|

|

||||||

|

## 1.1.2 当前工作目录

|

||||||

|

每个运行在计算机上的程序,都有一个“当前工作目录”。利用`os.getcwd()`函数,可以取得当前工作路径的

|

||||||

|

字符串,并可以利用`os.chdir()`改变它。

|

||||||

|

|

||||||

|

```python

|

||||||

|

import os

|

||||||

|

os.getcwd() #获取当前工作目录

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.chdir('D:\\Datawhale\\python办公自动化') #改变当前工作目录

|

||||||

|

os.getcwd()

|

||||||

|

```

|

||||||

|

|

||||||

|

## 1.1.3 路径操作

|

||||||

|

|

||||||

|

### 1.1.3.1 绝对路径和相对路径

|

||||||

|

“绝对路径”,总是从根文件夹开始。

|

||||||

|

“相对路径”,相对于程序的当前工作目录。

|

||||||

|

相对路径中,单个句点“.”表示当前目录的缩写,两个句点“..”表示父文件夹。

|

||||||

|

|

||||||

|

|

||||||

|

几个常用的绝对路径和相对路径处理函数

|

||||||

|

|

||||||

|

`os.path.abspath(path)`:将相对路径转换为绝对路径,将返回参数的绝对路径的字符串。`os.path.isabs(path)`:判断是否是绝对路径,是返回True,不是则返回False

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.path.abspath('.') #当前路径转化为绝对路径。 'D:\\Datawhale\\python办公自动化'

|

||||||

|

os.path.isabs('.') #False

|

||||||

|

os.path.isabs(os.path.abspath('.')) #True

|

||||||

|

```

|

||||||

|

|

||||||

|

### 1.1.3.2 路径操作

|

||||||

|

`os.path.relpath(path,start)`:返回从start路径到path的相对路径的字符串。如果没提供start,就使用当前工作目录作为开始路径。

|

||||||

|

`os.path.dirname(path)`: 返回当前路径的目录名称。

|

||||||

|

`os.path.basename(path)`:返回当前路径的文件名称。

|

||||||

|

|

||||||

|

```

|

||||||

|

os.path.relpath('D:\\Datawhale\\python办公自动化','D:\\') #'Datawhale\\python办公自动化'

|

||||||

|

```

|

||||||

|

|

||||||

|

```

|

||||||

|

path = 'D:\\Datawhale\\python办公自动化\\python课程画图.pptx'

|

||||||

|

os.path.dirname(path) #'D:\\Datawhale\\python办公自动化'

|

||||||

|

```

|

||||||

|

|

||||||

|

```

|

||||||

|

os.path.basename(path) #'python课程画图.pptx'

|

||||||

|

```

|

||||||

|

|

||||||

|

如果同时需要一个路径的目录名称和基本名称,可以调用`os.path.split()`,获得者两个字符串的元组。

|

||||||

|

|

||||||

|

```python

|

||||||

|

caFilePath = 'D:\\Datawhale\\python办公自动化\\python课程画图.pptx'

|

||||||

|

os.path.split(caFilePath) #('D:\\Datawhale\\python办公自动化', 'python课程画图.pptx')

|

||||||

|

```

|

||||||

|

|

||||||

|

```

|

||||||

|

我们也可以调用os.path.dirname()和os.path.basename(),将它们的返回值放在一个元组中,从而得到同样的元组。

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

(os.path.dirname(caFilePath),os.path.basename(caFilePath)) #('D:\\Datawhale\\python办公自动化', 'python课程画图.pptx')

|

||||||

|

```

|

||||||

|

|

||||||

|

如果我们想返回每个文件夹的字符串的列表。用`os.path.split()`无法得到,我们可以用`split()`字符串方法,并根据`os.path.sep` 中的字符串进行分割。`os.path.sep` 变量设置为正确的文件夹分割斜杠。

|

||||||

|

|

||||||

|

```python

|

||||||

|

caFilePath.split(os.path.sep) #['D:', 'Datawhale', 'python办公自动化', 'python课程画图.pptx']

|

||||||

|

```

|

||||||

|

|

||||||

|

### 1.1.3.3 路径有效性检查

|

||||||

|

如果提供的路径不存在,很多Python函数就会崩溃并报错。`os.path`模块提供了一些函数,用于检测给定的路径是否存在,以及判定是文件还是文件。

|

||||||

|

|

||||||

|

`os.path.exists(path)`:如果path参数所指的文件或文件夹存在,则返回True,否则返回False。

|

||||||

|

|

||||||

|

`os.path.isfile(path)`:如果path参数存在,并且是一个文件,则返回True,否则返回False。

|

||||||

|

|

||||||

|

`os.path.isdir(path)`:如果path参数存在,并且是一个文件夹,则返回True,否则返回False。

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.path.exists('C:\\Windows')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.path.exists('C:\\else')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.path.isfile('D:\\Datawhale\\python办公自动化\\python课程画图.pptx')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.path.isfile('D:\\Datawhale\\python办公自动化')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.path.isdir('D:\\Datawhale\\python办公自动化\\python课程画图.pptx')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.path.isdir('D:\\Datawhale\\python办公自动化')

|

||||||

|

```

|

||||||

|

|

||||||

|

## 1.1.4 文件及文件夹操作

|

||||||

|

|

||||||

|

### 1.1.4.1 用os.makedirs()创建新文件夹

|

||||||

|

注:`os.makedirs()`可以创建所有必要的中间文件夹。

|

||||||

|

|

||||||

|

```python

|

||||||

|

import os

|

||||||

|

os.makedirs('D:\\Datawhale\\practice') #查看目录,已创建,若文件夹已存在,不会覆盖,会报错

|

||||||

|

```

|

||||||

|

|

||||||

|

### 1.1.4.2 查看文件大小和文件夹内容

|

||||||

|

我们已经可以处理文件路径,这是操作文件及文件夹的基础。接下来,我们可以搜集特定文件和文件夹的信息。`os.path`模块提供了一些函数,用于查看文件的字节数以及给定文件夹中的文件和子文件夹。

|

||||||

|

`os.path.getsize(path)`:返回path参数中文件的字节数。

|

||||||

|

`os.listdir(path)`:返回文件名字符串的列表,包含path参数中的每个文件。

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.path.getsize('D:\\Datawhale\\python办公自动化\\python课程画图.pptx')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.listdir('D:\\Datawhale\\python办公自动化')

|

||||||

|

```

|

||||||

|

|

||||||

|

如果想知道目录下所有文件的总字节数,可以同时使用`os.path.getsize()`和`os.listdir()`

|

||||||

|

|

||||||

|

```python

|

||||||

|

totalSize = 0

|

||||||

|

for filename in os.listdir('D:\\Datawhale\\python办公自动化'):

|

||||||

|

totalSize = totalSize + os.path.getsize(os.path.join('D:\\Datawhale\\python办公自动化',filename))

|

||||||

|

print(totalSize)

|

||||||

|

```

|

||||||

|

|

||||||

|

## 1.1.6 文件读写过程

|

||||||

|

读写文件3个步骤:

|

||||||

|

|

||||||

|

1.调用`open()`函数,返回一个File对象。

|

||||||

|

|

||||||

|

2.调用File对象的`read()`或`write()`方法。

|

||||||

|

|

||||||

|

3.调用File对象的`close()`方法,关闭该文件。

|

||||||

|

|

||||||

|

### 1.1.6.1 用open()函数打开文件

|

||||||

|

要用`open()`函数打开一个文件,就要向它传递一个字符串路径,表明希望打开的文件。这既可以是绝对路径,也可以是相对路径。`open()`函数返回一个File对象。

|

||||||

|

先用TextEdit创建一个文本文件,名为hello.txt。输入Hello World!作为该文本文件的内容,将它保存在你的用户文件夹中。

|

||||||

|

|

||||||

|

```python

|

||||||

|

helloFile = open('D:\\Datawhale\\python办公自动化\\hello.txt')

|

||||||

|

print(helloFile)

|

||||||

|

```

|

||||||

|

|

||||||

|

可以看到,调用`open()`函数将会返回一个File对象。当你需要读取或写入该文件,就可以调用helloFile变量中的File对象的方法。

|

||||||

|

|

||||||

|

### 1.1.6.2 读取文件内容

|

||||||

|

有了File对象,我们就可以开始从它读取内容。

|

||||||

|

|

||||||

|

`read()`:读取文件内容。

|

||||||

|

|

||||||

|

`readlines()`:按行读取文件中的内容,取得一个字符串列表,列表中每个字符串是文本中的一行且以\n结束。

|

||||||

|

|

||||||

|

```python

|

||||||

|

helloContent = helloFile.read()

|

||||||

|

helloContent

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

sonnetFile = open('D:\\Datawhale\\python办公自动化\\hello.txt')

|

||||||

|

sonnetFile.readlines()

|

||||||

|

```

|

||||||

|

|

||||||

|

### 1.1.6.3 写入文件

|

||||||

|

需要用“写模式”‘w’和“添加模式”'a'打开一个文件,而不能用读模式打开文件。

|

||||||

|

“写模式”将覆写原有的文件,从头开始。“添加模式”将在已有文件的末尾添加文本。

|

||||||

|

|

||||||

|

```python

|

||||||

|

baconFile = open('bacon.txt','w')

|

||||||

|

baconFile.write('Hello world!\n')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

baconFile.close() #注意,关闭后,才能完成写入,从txt文件中看到写入的内容。

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

baconFile = open('bacon.txt','a')

|

||||||

|

baconFile.write('Bacon is not a vegetable.')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

baconFile.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

baconFile = open('bacon.txt')

|

||||||

|

content = baconFile.read()

|

||||||

|

baconFile.close()

|

||||||

|

print(content)

|

||||||

|

```

|

||||||

|

|

||||||

|

注意,`write()`方法不会像print()函数那样,在字符串的末尾自动添加换行字符。必须自己添加该字符。

|

||||||

|

|

||||||

|

### 1.1.6.3 保存变量

|

||||||

|

1)、shelve模块

|

||||||

|

|

||||||

|

用`shelve`模块,可以将Python中的变量保存到二进制的`shelf`文件中。这样,程序就可以从硬盘中恢复变量的数据。

|

||||||

|

|

||||||

|

```python

|

||||||

|

import shelve

|

||||||

|

shelfFile = shelve.open('mydata')

|

||||||

|

cats = ['Zonphie','Pooka','Simon']

|

||||||

|

shelfFile['cats'] = cats

|

||||||

|

shelfFile.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

在Windows上运行前面的代码,我们会看到当前工作目录下有3个新文件:mydata.bak、mydata.dat和mydata.dir。在OS X上,只会创建一个mydata.db文件。

|

||||||

|

|

||||||

|

重新打开这些文件,取出数据。注意:`shelf`值不必用读模式或写模式打开,因为打开后,既能读又能写。

|

||||||

|

|

||||||

|

```python

|

||||||

|

shelfFile = shelve.open('mydata')

|

||||||

|

type(shelfFile)

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

shelve.DbfilenameShelf

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

shelfFile['cats']

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

shelfFile.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

就像字典一样,`shelf`值有`keys()`和`values()`方法,返回shelf中键和值的类似列表的值。但是这些方法返回类似列表的值,却不是真正的列表,所以应该将它们传递给`list()`函数,取得列表的形式。

|

||||||

|

|

||||||

|

```python

|

||||||

|

shelfFile = shelve.open('mydata')

|

||||||

|

list(shelfFile.keys())

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

list(shelfFile.values())

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

shelfFile.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

2)、用`pprint.pformat()`函数保存变量

|

||||||

|

|

||||||

|

`pprint.pformat()`函数返回要打印的内容的文本字符串,这个字符串既易于阅读,也是语法上正确的Python代码。

|

||||||

|

|

||||||

|

假如,有一个字典,保存在一个变量中,希望保存这个变量和它的内容,以便将来使用。`pprint.pformat()`函数将提供一个字符串,我们可以将它写入.py文件。这个文件可以成为我们自己的模块,如果需要使用存储其中的变量,就可以导入它。

|

||||||

|

|

||||||

|

```python

|

||||||

|

import pprint

|

||||||

|

cats = [{'name':'Zophie','desc':'chubby'},{'name':'Pooka','desc':'fluffy'}]

|

||||||

|

pprint.pformat(cats)

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

fileObj = open('myCats.py','w')

|

||||||

|

fileObj.write('cats = '+pprint.pformat(cats)+'\n')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

fileObj.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

import语句导入的模块本身就是Python脚本。如果来自pprint.pformat()的字符串保存为一个.py文件,该文件就是一个可以导入的模块。

|

||||||

|

|

||||||

|

```python

|

||||||

|

import myCats

|

||||||

|

myCats.cats

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

myCats.cats[0]

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

myCats.cats[0]['name']

|

||||||

|

```

|

||||||

|

|

||||||

|

## 1.1.7 练习

|

||||||

|

|

||||||

|

1、如果已有的文件以写模式打开,会发生什么?

|

||||||

|

|

||||||

|

2、`read()`和`readlines()`方法之间的区别是什么?

|

||||||

|

|

||||||

|

综合练习:

|

||||||

|

一、生成随机的测验试卷文件

|

||||||

|

假如你是一位地理老师, 班上有 35 名学生, 你希望进行美国各州首府的一个

|

||||||

|

小测验。不妙的是,班里有几个坏蛋, 你无法确信学生不会作弊。你希望随机调整

|

||||||

|

问题的次序, 这样每份试卷都是独一无二的, 这让任何人都不能从其他人那里抄袭答案。当然,手工完成这件事又费时又无聊。 好在, 你懂一些 Python。

|

||||||

|

|

||||||

|

下面是程序所做的事:

|

||||||

|

|

||||||

|

• 创建 35 份不同的测验试卷。

|

||||||

|

|

||||||

|

• 为每份试卷创建 50 个多重选择题,次序随机。

|

||||||

|

|

||||||

|

• 为每个问题提供一个正确答案和 3 个随机的错误答案,次序随机。

|

||||||

|

|

||||||

|

• 将测验试卷写到 35 个文本文件中。

|

||||||

|

|

||||||

|

• 将答案写到 35 个文本文件中。

|

||||||

|

|

||||||

|

这意味着代码需要做下面的事:

|

||||||

|

|

||||||

|

• 将州和它们的首府保存在一个字典中。

|

||||||

|

|

||||||

|

• 针对测验文本文件和答案文本文件,调用 open()、 write()和 close()。

|

||||||

|

|

||||||

|

• 利用 random.shuffle()随机调整问题和多重选项的次序。

|

||||||

|

|

||||||

|

## 1.2 组织文件

|

||||||

|

|

||||||

|

在上一节中,已经学习了如何使用Python创建并写入新文件。本节将介绍如何用程序组织硬盘上已经存在的文件。不知你是否经历过查找一个文件夹,里面有几十个、几百个、甚至上千个文件,需要手工进行复制、改名、移动或压缩。比如下列这样的任务:

|

||||||

|

|

||||||

|

• 在一个文件夹及其所有子文件夹中,复制所有的 pdf 文件(且只复制 pdf 文件)

|

||||||

|

|

||||||

|

• 针对一个文件夹中的所有文件,删除文件名中前导的零,该文件夹中有数百个文件,名为 spam001.txt、 spam002.txt、 spam003.txt 等。

|

||||||

|

|

||||||

|

• 将几个文件夹的内容压缩到一个 ZIP 文件中(这可能是一个简单的备份系统)

|

||||||

|

|

||||||

|

所有这种无聊的任务,正是在请求用 Python 实现自动化。通过对电脑编程来完成这些任务,你就把它变成了一个快速工作的文件职员,而且从不犯错。

|

||||||

|

|

||||||

|

### 1.2.1 shutil模块

|

||||||

|

|

||||||

|

`shutil`(或称为shell工具)模块中包含一些函数,可以在Python程序中复制、移动、改名和删除文件。要使用`shutil`的函数,首先需要`import shutil`

|

||||||

|

|

||||||

|

#### 1.2.1.1 复制文件和文件夹

|

||||||

|

|

||||||

|

`shutil.copy(source, destination)`:将路径source处的文件复制到路径 destination处的文件夹(source 和 destination 都是字符串),并返回新复制文件绝对路径字符串。

|

||||||

|

|

||||||

|

其中destination可以是:

|

||||||

|

|

||||||

|

1)、一个文件的名称,则将source文件复制为新名称的destination

|

||||||

|

|

||||||

|

2)、一个文件夹,则将source文件复制到destination中

|

||||||

|

|

||||||

|

3)、若这个文件夹不存在,则将source目标文件内的内容复制到destination中,若destination文件夹不存在,则自动生成该文件。(慎用,因为会将source文件复制为一个没有扩展名的名字为destination的文件,这往往不是我们希望的)

|

||||||

|

|

||||||

|

```python

|

||||||

|

import shutil

|

||||||

|

shutil.copy('D:\\Datawhale\\python办公自动化\\bacon.txt', 'D:\\Datawhale\\practice')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

os.getcwd()

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

shutil.copy('D:\\Datawhale\\python办公自动化\\capitalsquiz_answers1.txt', 'D:\\Datawhale\\practice\\bacon.txt')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

shutil.copy('D:\\Datawhale\\python办公自动化\\bacon.txt', 'D:\\Datawhale\\exercise')

|

||||||

|

```

|

||||||

|

|

||||||

|

`shutil.copytree(source, destination)` :将路径source处的文件夹,包括其包含的文件夹和文件,复制到路径destination处的文件夹,并返回新复制文件夹绝对路径字符串。

|

||||||

|

|

||||||

|

注:destination处的文件夹为新创建的文件夹,如已存在,则会报错

|

||||||

|

|

||||||

|

```python

|

||||||

|

import shutil

|

||||||

|

shutil.copytree('D:\\Datawhale\\python办公自动化','D:\\Datawhale\\practice')

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 1.2.1.2 文件和文件夹的移动与改名

|

||||||

|

|

||||||

|

`shutil.move(source, destination)`:将路径 source 处的文件/文件夹移动到路径destination,并返回新位置的绝对路径的字符串。

|

||||||

|

|

||||||

|

1)、如果source和destination是文件夹,且destination已存在,则会将source文件夹下所有内容复制到destination文件夹中。移动。

|

||||||

|

|

||||||

|

2)、如果source是文件夹,destination不存在,则会将source文件夹下所有内容复制到destination文件夹中,source原文件夹名称将被替换为destination文件夹名。 移动+重命名

|

||||||

|

|

||||||

|

3)、如果source和destination是文件,source处的文件将被移动到destination处的位置,并以destination处的文件名进行命名,移动+重命名。

|

||||||

|

|

||||||

|

注意:如果destination中有原来已经存在同名文件,移动后,会被覆写,所以应当特别注意。

|

||||||

|

|

||||||

|

```python

|

||||||

|

import shutil

|

||||||

|

shutil.move('D:\\Datawhale\\practice','D:\\Datawhale\\docu')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

shutil.move('D:\\Datawhale\\practice','D:\\Datawhale\\docue')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

shutil.move('D:\\Datawhale\\docue\\bacon.txt','D:\\Datawhale\\docu\\egg.txt')

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 1.2.1.3 永久删除文件和文件夹

|

||||||

|

`os.unlink(path)`: 删除path处的文件。

|

||||||

|

|

||||||

|

`os.rmdir(path)`: 删除path处的文件夹。该文件夹必须为空,其中没有任何文件和文件夹。

|

||||||

|

|

||||||

|

`shutil.rmtree(path)`:删除 path 处的文件夹,它包含的所有文件和文件夹都会被删除。

|

||||||

|

|

||||||

|

注意:使用时,需要非常小心,避免删错文件,一般在第一次运行时,注释掉这些程序,并加上`print()`函数来帮助查看是否是想要删除的文件。

|

||||||

|

|

||||||

|

```python

|

||||||

|

#建议先指定操作的文件夹,并查看

|

||||||

|

os.chdir('D:\\Datawhale\\docue')

|

||||||

|

os.getcwd()

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

import os

|

||||||

|

for filename in os.listdir():

|

||||||

|

if filename.endswith('.dir'):

|

||||||

|

#os.unlink(filename)

|

||||||

|

print(filename)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 1.2.1.4 用send2trash模块安全地删除

|

||||||

|

`shutil.rmtree(path)`会不可恢复的删除文件和文件夹,用起来会有危险。因此使用第三方的`send2trash`模块,可以将文件或文件夹发送到计算机的垃圾箱或回收站,而不是永久删除。因程序缺陷而用send2trash 删除的某些你不想删除的东西,稍后可以从垃圾箱恢复。

|

||||||

|

|

||||||

|

注意:使用时,需要非常小心,避免删错文件,一般在第一次运行时,注释掉这些程序,并加上`print()`函数来帮助查看是否是想要删除的文件。

|

||||||

|

|

||||||

|

```python

|

||||||

|

pip install send2trash #安装send2trash模块

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

import send2trash

|

||||||

|

send2trash.send2trash('bacon.txt')

|

||||||

|

```

|

||||||

|

|

||||||

|

## 1.2.2 遍历目录树

|

||||||

|

`os.walk(path)`:传入一个文件夹的路径,在for循环语句中使用`os.walk()`函数,遍历目录树,和range()函数遍历一个范围的数字类似。不同的是,`os.walk()`在循环的每次迭代中,返回三个值:

|

||||||

|

|

||||||

|

1)、当前文件夹称的字符串。

|

||||||

|

|

||||||

|

2)、当前文件夹中子文件夹的字符串的列表。

|

||||||

|

|

||||||

|

3)、当前文件夹中文件的字符串的列表。

|

||||||

|

|

||||||

|

注:当前文件夹,是指for循环当前迭代的文件夹。程序的当前工作目录,不会因为`os.walk()`而改变。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

按照下图目录树,创建相应的文件。

|

||||||

|

|

||||||

|

|

||||||

|

```python

|

||||||

|

import os

|

||||||

|

for folderName, subFolders,fileNames in os.walk('D:\\animals'):

|

||||||

|

print('The current folder is ' + folderName)

|

||||||

|

for subFolder in subFolders:

|

||||||

|

print('Subfolder of ' + folderName+':'+subFolder)

|

||||||

|

for filename in fileNames:

|

||||||

|

print('File Inside ' + folderName+':'+filename)

|

||||||

|

print('')

|

||||||

|

```

|

||||||

|

|

||||||

|

## 1.2.3 用zipfile模块压缩文件

|

||||||

|

|

||||||

|

为方便传输,常常将文件打包成.zip格式文件。利用zipfile模块中的函数,Python程序可以创建和打开(或解压)zip文件。

|

||||||

|

|

||||||

|

### 1.2.3.1 创建和添加到zip文件

|

||||||

|

|

||||||

|

将上述章节中animals文件夹进行压缩。创建一个example.zip的zip文件,并向其中添加文件。

|

||||||

|

|

||||||

|

`zipfile.ZipFile('filename.zip', 'w')` :以写模式创建一个压缩文件

|

||||||

|

|

||||||

|

`ZipFile` 对象的 `write('filename','compress_type=zipfile.ZIP_DEFLATED')`方法:如果向`write()`方法中传入一个路径,Python 就会压缩该路径所指的文件, 将它加到 ZIP 文件中。 如果向`write()`方法中传入一个字符串,代表要添加的文件名。第二个参数是“压缩类型”参数,告诉计算机用怎样的算法来压缩文件。可以总是将这个值设置为 `zipfile.ZIP_DEFLATED`(这指定了 deflate 压缩算法,它对各种类型的数据都很有效)。

|

||||||

|

|

||||||

|

注意:写模式会擦除zip文件中所有原有的内容。如果只希望将文件添加到原有的zip文件中,就要向`zipfile.ZipFile()`传入'a'作为第二个参数,以添加模式打开 ZIP 文件。

|

||||||

|

|

||||||

|

```python

|

||||||

|

## 1 创建一个new.zip压缩文件,并向其中添加文件

|

||||||

|

import zipfile

|

||||||

|

newZip = zipfile.ZipFile('new.zip','w')

|

||||||

|

newZip.write('Miki.txt',compress_type=zipfile.ZIP_DEFLATED)

|

||||||

|

newZip.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

newZip = zipfile.ZipFile('new.zip','w')

|

||||||

|

newZip.write('D:\\animals\\dogs\\Taidi.txt',compress_type=zipfile.ZIP_DEFLATED)

|

||||||

|

newZip.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

## 2 创建一个example.zip的压缩文件,将animals文件夹下所有文件进行压缩。

|

||||||

|

import zipfile

|

||||||

|

import os

|

||||||

|

newZip = zipfile.ZipFile('example.zip','w')

|

||||||

|

for folderName, subFolders,fileNames in os.walk('D:\\animals'):

|

||||||

|

for filename in fileNames:

|

||||||

|

newZip.write(os.path.join(folderName,filename),compress_type=zipfile.ZIP_DEFLATED)

|

||||||

|

newZip.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

### 1.2.3.2 读取zip文件

|

||||||

|

|

||||||

|

调用`zipfile.ZipFile(filename)`函数创建一个`ZipFile`对象(注意大写字母Z和F),filename是要读取zip文件的文件名。

|

||||||

|

|

||||||

|

`ZipFile`对象中的两个常用方法:

|

||||||

|

|

||||||

|

`namelis()`方法,返回zip文件中包含的所有文件和文件夹的字符串列表。

|

||||||

|

|

||||||

|

`getinfo()`方法,返回一个关于特定文件的`ZipInfo`对象。

|

||||||

|

|

||||||

|

`ZipInfo`对象的两个属性:`file_size`和`compress_size`,分别表示原来文件大小和压缩后文件大小。1.2.3.2 读取zip文件

|

||||||

|

|

||||||

|

```

|

||||||

|

import zipfile,os

|

||||||

|

exampleZip = zipfile.ZipFile('example.zip')

|

||||||

|

exampleZip.namelist()

|

||||||

|

```

|

||||||

|

|

||||||

|

```

|

||||||

|

catInfo = exampleZip.getinfo('animals/Miki.txt')

|

||||||

|

```

|

||||||

|

|

||||||

|

```

|

||||||

|

catInfo.file_size

|

||||||

|

```

|

||||||

|

|

||||||

|

```

|

||||||

|

catInfo.compress_size

|

||||||

|

```

|

||||||

|

|

||||||

|

```

|

||||||

|

print('Compressed file is %s x smaller!' %(round(catInfo.file_size/catInfo.compress_size,2)))

|

||||||

|

```

|

||||||

|

|

||||||

|

```

|

||||||

|

exampleZip.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

### 1.2.3.3 从zip文件中解压缩

|

||||||

|

|

||||||

|

`ZipFile` 对象的 `extractall()`方法:从zip文件中解压缩所有文件和文件夹,放到当前工作目录中。也可以向`extractall()`传递的一个文件夹名称,它将文件解压缩到那个文件夹, 而不是当前工作目录。如果传递的文件夹名称不存在,就会被创建。

|

||||||

|

|

||||||

|

`ZipFile` 对象的 `extract()`方法:从zip文件中解压单个文件。也可以向 extract()传递第二个参数, 将文件解压缩到指定的文件夹, 而不是当前工作目录。如果第二个参数指定的文件夹不存在, Python 就会创建它。extract()的返回值是被压缩后文件的绝对路径。

|

||||||

|

|

||||||

|

```python

|

||||||

|

import zipfile, os

|

||||||

|

exampleZip = zipfile.ZipFile('example.zip')

|

||||||

|

exampleZip.extractall('.\zip')

|

||||||

|

exampleZip.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

exampleZip = zipfile.ZipFile('example.zip')

|

||||||

|

exampleZip.extract('animals/Miki.txt')

|

||||||

|

exampleZip.extract('animals/Miki.txt', 'D:\\animals\\folders')

|

||||||

|

exampleZip.close()

|

||||||

|

```

|

||||||

|

|

||||||

|

## 1.2.4 练习

|

||||||

|

|

||||||

|

1)、编写一个程序,遍历一个目录树,查找特定扩展名的文件(诸如.pdf 或.jpg)。不论这些文件的位置在哪里, 将它们拷贝到一个新的文件夹中。

|

||||||

|

|

||||||

|

2) 、一些不需要的、 巨大的文件或文件夹占据了硬盘的空间, 这并不少见。如果你试图释放计算机上的空间, 那么删除不想要的巨大文件效果最好。但首先你必须找到它们。编写一个程序, 遍历一个目录树, 查找特别大的文件或文件夹, 比方说, 超过100MB 的文件(回忆一下,要获得文件的大小,可以使用 os 模块的 `os.path.getsize()`)。将这些文件的绝对路径打印到屏幕上。

|

||||||

|

|

||||||

|

3)、编写一个程序, 在一个文件夹中, 找到所有带指定前缀的文件, 诸如 spam001.txt,spam002.txt 等,并定位缺失的编号(例如存在 spam001.txt 和 spam003.txt, 但不存在 spam002.txt)。让该程序对所有后面的文件改名, 消除缺失的编号。作为附加的挑战,编写另一个程序,在一些连续编号的文件中,空出一些编号,以便加入新的文件。

|

||||||

|

|

||||||

|

## 2 自动发送电子邮件

|

||||||

|

|

||||||

|

使用Python实现自动化邮件发送,可以让你摆脱繁琐的重复性业务,节省非常多的时间。

|

||||||

|

|

||||||

|

Python有两个内置库:`smtplib`和`email`,能够实现邮件功能,`smtplib`库负责发送邮件,`email`库负责构造邮件格式和内容。

|

||||||

|

|

||||||

|

邮件发送需要遵守**SMTP**协议,Python内置对SMTP的支持,可以发送纯文本邮件、HTML邮件以及带附件的邮件。

|

||||||

|

|

||||||

|

```python

|

||||||

|

#1 先导入相关的库和方法

|

||||||

|

import smtplib #导入库

|

||||||

|

from smtplib import SMTP_SSL #加密邮件内容,防止中途被截获

|

||||||

|

from email.mime.text import MIMEText #构造邮件的正文

|

||||||

|

from email.mime.image import MIMEImage #构造邮件的图片

|

||||||

|

from email.mime.multipart import MIMEMultipart #把邮件的各个部分装在一起,邮件的主体

|

||||||

|

from email.header import Header #邮件的文件头,标题,收件人

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

#2 设置邮箱域名、发件人邮箱、邮箱授权码、收件人邮箱

|

||||||

|

host_server = 'smtp.163.com' #sina 邮箱smtp服务器 #smtp 服务器的地址

|

||||||

|

sender_163 = 'pythonauto_emai@163.com' #sender_163为发件人的邮箱

|

||||||

|

pwd = 'DYEPOGLZDZYLOMRI' #pwd为邮箱的授权码'DYEPOGLZDZYLOMRI'

|

||||||

|

#也可以自己注册个邮箱,邮箱授权码'DYEPOGLZDZYLOMRI' 获取方式可参考#http://help.163.com/14/0923/22/A6S1FMJD00754KNP.html

|

||||||

|

receiver = '********@163.com'

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

#3 构建MIMEMultipart对象代表邮件本身,可以往里面添加文本、图片、附件等

|

||||||

|

msg = MIMEMultipart() #邮件主体

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

#4 设置邮件头部内容

|

||||||

|

mail_title = 'python办公自动化邮件' # 邮件标题

|

||||||

|

msg["Subject"] = Header(mail_title,'utf-8') #装入主体

|

||||||

|

msg["From"] = sender_163 #寄件人

|

||||||

|

msg["To"] = Header("测试邮箱",'utf-8') #标题

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

#5 添加正文文本

|

||||||

|

mail_content = "您好,这是使用python登录163邮箱发送邮件的测试" #邮件的正文内容

|

||||||

|

message_text = MIMEText(mail_content,'plain','utf-8') #构造文本,参数1:正文内容,参数2:文本格式,参数3:编码方式

|

||||||

|

msg.attach(message_text) # 向MIMEMultipart对象中添加文本对象

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

#6 添加图片

|

||||||

|

image_data = open('cat.jpg','rb') # 二进制读取图片

|

||||||

|

message_image = MIMEImage(image_data.read()) # 设置读取获取的二进制数据

|

||||||

|

image_data.close() # 关闭刚才打开的文件

|

||||||

|

msg.attach(message_image) # 添加图片文件到邮件信息当中去

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

# 7 添加附件(excel表格)

|

||||||

|

atta = MIMEText(open('cat.xlsx', 'rb').read(), 'base64', 'utf-8') # 构造附件

|

||||||

|

atta["Content-Disposition"] = 'attachment; filename="cat.xlsx"' # 设置附件信息

|

||||||

|

msg.attach(atta) ## 添加附件到邮件信息当中去

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

#8 发送邮件

|

||||||

|

smtp = SMTP_SSL(host_server) #SSL登录 创建SMTP对象

|

||||||

|

smtp.login(sender_163,pwd) ## 登录邮箱,传递参数1:邮箱地址,参数2:邮箱授权码

|

||||||

|

smtp.sendmail(sender_163,receiver,msg.as_string()) # 发送邮件,传递参数1:发件人邮箱地址,参数2:收件人邮箱地址,参数3:把邮件内容格式改为str

|

||||||

|

print("邮件发送成功")

|

||||||

|

smtp.quit # 关闭SMTP对象

|

||||||

|

```

|

||||||

|

|

||||||

|

|

@ -0,0 +1,396 @@

|

||||||

|

# Python自动化之Excel

|

||||||

|

|

||||||

|

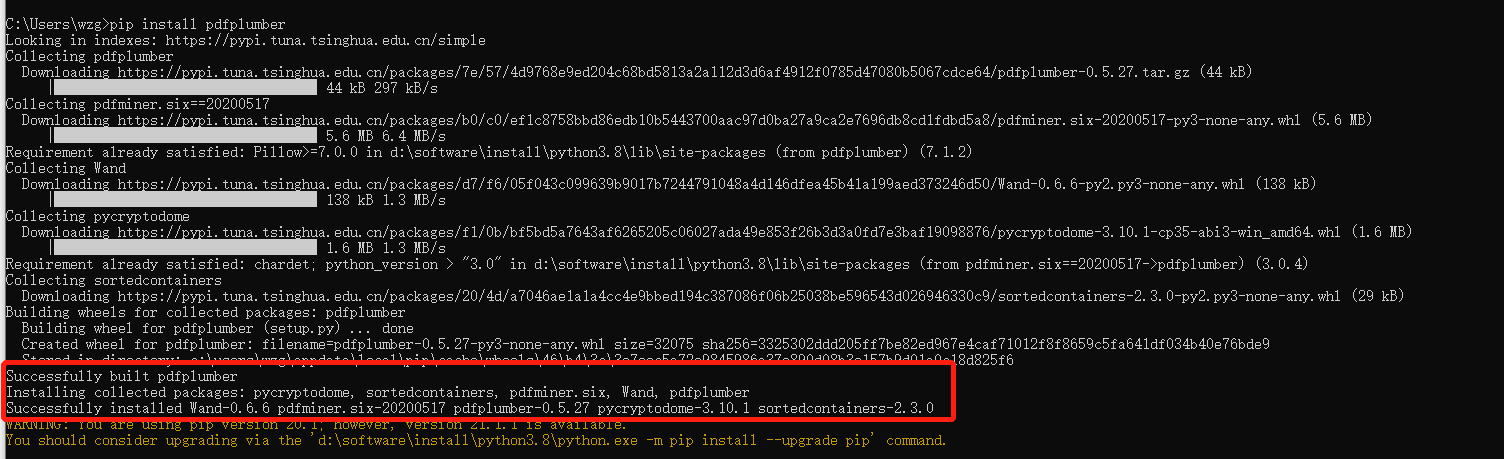

方法一:应用pip执行命令

|

||||||

|

|

||||||

|

安装**openpyxl**模块`pip install openpyxl`

|

||||||

|

|

||||||

|

方法二:在Pycharm中:File->Setting->左侧Project Interpreter

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

### Excel读取

|

||||||

|

|

||||||

|

#### 读取对应表格

|

||||||

|

|

||||||

|

1. 打开已经存在的Excel表格

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl imporg load_workbook

|

||||||

|

|

||||||

|

exl = load_workbook(filename = 'test.xlsx')

|

||||||

|

print(elx.sheetnames)

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 根据名称或去表格

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import load_workbook

|

||||||

|

|

||||||

|

exl_1 = load_workbook(filename = 'test.xlsx')

|

||||||

|

print(exl_1.sheetnames)

|

||||||

|

|

||||||

|

sheet = elx_1['work']

|

||||||

|

|

||||||

|

'若只有一张表则:'

|

||||||

|

sheet = elx_1.active

|

||||||

|

```

|

||||||

|

|

||||||

|

3. 获取Excel 内容占据的大小

|

||||||

|

|

||||||

|

```

|

||||||

|

print(sheet.dimensions)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 读取单元格

|

||||||

|

|

||||||

|

1. 获取某个单元格的具体内容

|

||||||

|

|

||||||

|

```

|

||||||

|

cell = sheet.cell(row=1,column=2) #指定行列数

|

||||||

|

print(cell.value)

|

||||||

|

|

||||||

|

cell_1 = sheet['A1'] #指定坐标

|

||||||

|

print(cell_1.value)

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 获取单元格对应的行、列和坐标

|

||||||

|

|

||||||

|

```

|

||||||

|

print(cell_1.row, cell_column, cell.coordinate)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 读取多个格子的值

|

||||||

|

|

||||||

|

1. 指定坐标范围

|

||||||

|

|

||||||

|

```

|

||||||

|

cells = sheet['A1:C8'] #A1到C8区域的值

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 指定行的值

|

||||||

|

|

||||||

|

```

|

||||||

|

Row = sheet[1] #第1行的值

|

||||||

|

Rows = sheet[1:2] #第1到2行的值

|

||||||

|

```

|

||||||

|

|

||||||

|

3. 指定列的值

|

||||||

|

|

||||||

|

```

|

||||||

|

Column = sheet['A'] #第A列

|

||||||

|

Columns = sheet['A:C'] #第A到C列

|

||||||

|

```

|

||||||

|

|

||||||

|

4. 指定范围的值

|

||||||

|

|

||||||

|

```

|

||||||

|

# 行获取

|

||||||

|

for row in sheet.iter_rows(min_row = 1, max_row = 5,

|

||||||

|

min_col = 2, max_col = 6):

|

||||||

|

print(row)

|

||||||

|

# 一列由多个单元格组成,若需要获取每个单元格的值则循环获取即可

|

||||||

|

for cell in row:

|

||||||

|

print(cell.value)

|

||||||

|

|

||||||

|

# 列获取

|

||||||

|

for col in sheet.iter_cols(min_row = 1, max_row = 5,

|

||||||

|

min_col = 2, max_col = 6):

|

||||||

|

print(col)

|

||||||

|

|

||||||

|

for cell in col:

|

||||||

|

print(cell.value)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 练习题

|

||||||

|

|

||||||

|

找出text_1.xlsx中sheet1表中空着的格子,并输出这些格子的坐标

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import load_workbook

|

||||||

|

|

||||||

|

exl = load_workbood('test_1.xlsx')

|

||||||

|

sheet = exl.active

|

||||||

|

for row in sheet.iter_rows(min_row = 1, max_row = 29972,

|

||||||

|

min_col = 1, max_col = 10):

|

||||||

|

#具体查看对应表格的行列数

|

||||||

|

for cell in row:

|

||||||

|

if not cell.value:

|

||||||

|

print(cell.coordinate)

|

||||||

|

```

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

### Excel写入

|

||||||

|

|

||||||

|

#### 写入单元格并保存

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import load_workbook

|

||||||

|

|

||||||

|

exl = load_workbook(filename = 'test.xlsx')

|

||||||

|

sheet = exl.active

|

||||||

|

sheet['A1'] = 'hello word'

|

||||||

|

#或者cell = sheet['A1']

|

||||||

|

#cell.value = 'hello word'

|

||||||

|

exl.save(filename = 'test.xlsx') #存入原Excel表中,若创建新文件则可命名为不同名称

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 写入行数据并保存

|

||||||

|

|

||||||

|

1. 写入一行数据并保存

|

||||||

|

|

||||||

|

```

|

||||||

|

import wlwt

|

||||||

|

# 应用write中的参数,对应 行, 列, 值

|

||||||

|

sheet.write(1,0, label = 'this is test')

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 写入多行数据并保存

|

||||||

|

|

||||||

|

```

|

||||||

|

#应用sheet.append()

|

||||||

|

data = [['hello',22,'hi'],

|

||||||

|

['hell',23,'h'],

|

||||||

|

['he',25,'him']]

|

||||||

|

for i in data:

|

||||||

|

sheet.append(i)

|

||||||

|

exl.save(filename = 'test.xlsx')

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 将公式写入单元格保存

|

||||||

|

|

||||||

|

```

|

||||||

|

sheet['A2'] = 'SUM(A1:D1)'

|

||||||

|

exl.save(filename='test.xlsx')

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 插入列数据

|

||||||

|

|

||||||

|

1. 插入一列

|

||||||

|

|

||||||

|

```

|

||||||

|

sheet.insert_cols(idx=2) #idx=2第2列,第2列前插入一列

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 插入多列

|

||||||

|

|

||||||

|

```

|

||||||

|

#第2列前插入5列作为举例

|

||||||

|

sheet.insert_cols(idx=2, amount=5)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 插入行数据

|

||||||

|

|

||||||

|

第2行前上面插入一行(或多行)

|

||||||

|

|

||||||

|

```

|

||||||

|

#插入一行

|

||||||

|

sheet.insert_cols(idx=2)

|

||||||

|

#插入多行

|

||||||

|

sheet.insert_cols(idx=2, amount=5)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 删除

|

||||||

|

|

||||||

|

1. 删除多列

|

||||||

|

|

||||||

|

```

|

||||||

|

sheet.delete_cols(idx=5, amount=2) #第5列前删除2列

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 删除多行

|

||||||

|

|

||||||

|

```

|

||||||

|

sheet.delete_rows(idx=2, amount=5)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 移动

|

||||||

|

|

||||||

|

当数字为正即向下或向右,为负即为向上或向左

|

||||||

|

|

||||||

|

```

|

||||||

|

sheet.move_range('C5:F10', row=2, cols=-3)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### Sheet表操作

|

||||||

|

|

||||||

|

1. 创建新的sheet

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import load_workbook

|

||||||

|

|

||||||

|

exl = load_workbook(filename = 'test.xlsx')

|

||||||

|

print(exl.sheetnames)

|

||||||

|

|

||||||

|

exl.create_sheet('new_sheet')

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 复制已有的sheet

|

||||||

|

|

||||||

|

```

|

||||||

|

exl.copy_worksheet(sheet)

|

||||||

|

```

|

||||||

|

|

||||||

|

3. 修改sheet表名

|

||||||

|

|

||||||

|

```

|

||||||

|

sheet = exl.active

|

||||||

|

sheet.title = 'newname'

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 创建新的Excel表

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import load_workbook

|

||||||

|

|

||||||

|

workbook = Workbook()

|

||||||

|

sheet = workbook.active

|

||||||

|

workbook.save(filename = 'newtest.xlsx')

|

||||||

|

```

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

### Excel 样式

|

||||||

|

|

||||||

|

#### 设置字体样式

|

||||||

|

|

||||||

|

1. 设置字体样式

|

||||||

|

|

||||||

|

`Font(name字体名称,size大小,bold粗体,italic斜体,color颜色)`

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import Workbook

|

||||||

|

from openpyxl.styles import Font

|

||||||

|

|

||||||

|

workbook = Workbook()

|

||||||

|

sheet = workbook.active

|

||||||

|

cell = sheet['A1']

|

||||||

|

font = Font(name='字体', sizee=10, bold=True, italic=True, color='FF0000')

|

||||||

|

cell.font = font

|

||||||

|

workbook.save(filename='new_test')

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 设置多个格子的字体样式

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import Workbook

|

||||||

|

from openpyxl.styles import Font

|

||||||

|

|

||||||

|

workbook = Workbook()

|

||||||

|

sheet = workbook.active

|

||||||

|

cells = sheet[2]

|

||||||

|

font = Font(name='字体', sizee=10, bold=True, italic=True, color='FF000000')

|

||||||

|

for cell in cells:

|

||||||

|

cell.font = font

|

||||||

|

workbook.save(filename='new_test')

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 设置对其样式

|

||||||

|

|

||||||

|

水平对齐:`distributed, justify, center, left, fill, centerContinuous, right, general`

|

||||||

|

|

||||||

|

垂直对齐:`bottom, distributed, justify, center, top`

|

||||||

|

|

||||||

|

1. 设置单元格边框样式

|

||||||

|

|

||||||

|

`Side(style变现样式, color边线颜色)`

|

||||||

|

|

||||||

|

`Border(左右上下边线)`

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import Workbook

|

||||||

|

from openpyxl.styles import Font

|

||||||

|

|

||||||

|

workbook = Workbook()

|

||||||

|

sheet = workbook.active

|

||||||

|

cell = sheet['A1']

|

||||||

|

side = Side(style='thin', color='FF000000')

|

||||||

|

#先定好side的格式

|

||||||

|

border = Border(left=side, right=side, top=side, bottom=side)

|

||||||

|

#代入边线中

|

||||||

|

cell.border = border

|

||||||

|

workbook.save(filename='new_test')

|

||||||

|

```

|

||||||

|

|

||||||

|

2. 设置单元格边框样式

|

||||||

|

|

||||||

|

变现样式:`double, mediumDashDotDot, slantDashDot, dashDotDot, dotted, hair, mediumDashed, dashed, dashDot, thin, mediumDashDot, medium, thick `

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import Workbook

|

||||||

|

from openpyxl.styles import Font

|

||||||

|

|

||||||

|

workbook = Workbook()

|

||||||

|

sheet = workbook.active

|

||||||

|

cell = sheet['A1']

|

||||||

|

pattern_fill = PatternFill(fill_type='solid', fgColor

|

||||||

|

cell1.fill = pattern_fill

|

||||||

|

#单色填充

|

||||||

|

cell2 = sheet['A3']

|

||||||

|

gradient_fill = GradientFill(stop=('FFFFFF', '99ccff','000000'))

|

||||||

|

cell2.fill = gradient_fill

|

||||||

|

#渐变填充

|

||||||

|

workbook.save(filename='new_test')

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 设置行高与列宽

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import Workbook

|

||||||

|

|

||||||

|

workbook = Workbook()

|

||||||

|

sheet = workbook.active

|

||||||

|

sheet.row_dimensions[1].height = 50

|

||||||

|

sheet.column_dimensions['C'].width = 20 workbook.save(filename='new_test')

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 合并、取消合并单元格

|

||||||

|

|

||||||

|

```

|

||||||

|

sheet.merge_cells('A1:B2')

|

||||||

|

sheet.merge_cells(start_row=1, start_column=3,

|

||||||

|

end_row=2, end_column=4)

|

||||||

|

|

||||||

|

sheet.unmerge_cells('A1:B2')

|

||||||

|

sheet.unmerge_cells(start_row=1, start_column=3,

|

||||||

|

end_row=2, end_column=4)

|

||||||

|

```

|

||||||

|

|

||||||

|

#### 练习题

|

||||||

|

|

||||||

|

```

|

||||||

|

from openpyxl import load_workbook

|

||||||

|

from openpyxl.styles import Font, Side, Border

|

||||||

|

|

||||||

|

workbook = load_workbook('./test.xlsx')

|

||||||

|

sheet = workbook.active

|

||||||

|

buy_mount = sheet['F']

|

||||||

|

row_lst = []

|

||||||

|

|

||||||

|

for cell in buy_mount:

|

||||||

|

if isinstance(cell.value, int) and cell.value > 5:

|

||||||

|

print(cell.row)

|

||||||

|

row_lst.append(cell.row)

|

||||||

|

|

||||||

|

side = Side(style='thin', color='FF000000')

|

||||||

|

border = Border(left=side, right=side, top=side, bottom=side)

|

||||||

|

font = Font(bold=True, color='FF0000')

|

||||||

|

for row in row_lst:

|

||||||

|

for cell in sheet[row]:

|

||||||

|

cell.font = font

|

||||||

|

cell.border = border

|

||||||

|

workbook.save('new_test'.xlsx')

|

||||||

|

```

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

@ -0,0 +1,444 @@

|

||||||

|

# python自动化之word操作

|

||||||

|

|

||||||

|

[TOC]

|

||||||

|

|

||||||

|

|

||||||

|

## 一、课前准备

|

||||||

|

|

||||||

|

> python 处理 Word 需要用到 python-docx 库,终端执行如下安装命令:

|

||||||

|

|

||||||

|

```pyhton

|

||||||

|

pip3 install python-docx

|

||||||

|

```

|

||||||

|

|

||||||

|

> 或在pycharm的setting操作安装(示意如下):

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## 二、知识要点

|

||||||

|

|

||||||

|

> 说明:

|

||||||

|

> 1. 通过小试牛刀初步认识docx,然后系统学习python对word的操作;

|

||||||

|

> 2. 预估每个知识点需要讲解的时间;

|

||||||

|

> 3. 研发逻辑就是讲解逻辑,一般从上往下,遵循:`What - Why - How` 或 `Why - What - How` 思路;

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

### 1.预热:初步认识docx

|

||||||

|

|

||||||

|

相信同学们都进行过word的操作。话不多说,直接上python对word简单操作的代码,先有个直观的感觉,然后再系统学习!

|

||||||

|

|

||||||

|

#### (1)新建空白word并插入文字

|

||||||

|

|

||||||

|

```python

|

||||||

|

# 导入库

|

||||||

|

from docx import Document

|

||||||

|

|

||||||

|

# 新建空白文档

|

||||||

|

doc_1 = Document()

|

||||||

|

|

||||||

|

# 添加标题(0相当于文章的题目,默认级别是1,级别范围为0-9)

|

||||||

|

doc_1.add_heading('新建空白文档标题,级别为0',level = 0)

|

||||||

|

doc_1.add_heading('新建空白文档标题,级别为1',level = 1)

|

||||||

|

doc_1.add_heading('新建空白文档标题,级别为2',level = 2)

|

||||||

|

|

||||||

|

# 新增段落

|

||||||

|

paragraph_1 = doc_1.add_paragraph('这是第一段文字的开始\n请多多关照!')

|

||||||

|

# 加粗

|

||||||

|

paragraph_1.add_run('加粗字体').bold = True

|

||||||

|

paragraph_1.add_run('普通字体')

|

||||||

|

# 斜体

|

||||||

|

paragraph_1.add_run('斜体字体').italic =True

|

||||||

|

|

||||||

|

# 新段落(当前段落的下方)

|

||||||

|

paragraph_2 = doc_1.add_paragraph('新起的第二段文字。')

|

||||||

|

|

||||||

|

# 新段落(指定端的上方)

|

||||||

|

prior_paragraph = paragraph_1.insert_paragraph_before('在第一段文字前插入的段落')

|

||||||

|

|

||||||

|

# 添加分页符(可以进行灵活的排版)

|

||||||

|

doc_1.add_page_break()

|

||||||

|

# 新段落(指定端的上方)

|

||||||

|

paragraph_3 = doc_1.add_paragraph('这是第二页第一段文字!')

|

||||||

|

|

||||||

|

# 保存文件(当前目录下)

|

||||||

|

doc_1.save('doc_1.docx')

|

||||||

|

```

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

### 2. 正式:python自动化之word操作

|

||||||

|

|

||||||

|

上节只是小试牛刀一下,接下来我们系统地学习python自动化之word操作。

|

||||||

|

|

||||||

|

在操作之前,我们需要了解 Word 文档的<font color=red>页面结构</font> :

|

||||||

|

|

||||||

|

- 文档 - Document

|

||||||

|

- 段落 - Paragraph

|

||||||

|

- 文字块 - Run

|

||||||

|

|

||||||

|

**`python-docx`**将整个文章看做是一个**`Document`**对象 ,其基本结构如下:

|

||||||

|

|

||||||

|

- 每个**`Document`**包含许多个代表“段落”的**`Paragraph`**对象,存放在**`document.paragraphs`**中。

|

||||||

|

- 每个**`Paragraph`**都有许多个代表"行内元素"的**`Run`**对象,存放在**`paragraph.runs`**中。

|

||||||

|

|

||||||

|

在**`python-docx`**中,**`run`**是最基本的单位,每个**`run`**对象内的文本样式都是一致的,也就是说,在从**`docx`**文件生成文档对象时,**`python-docx`**会根据样式的变化来将文本切分为一个个的`Run`对象。

|

||||||

|

|

||||||

|

#### (1)整体页面结构介绍

|

||||||

|

|

||||||

|

我们以一个小案例为主线把文档,段落和文字块串一下:

|

||||||

|

|

||||||

|

```python

|

||||||

|

# 导入库

|

||||||

|

from docx import Document

|

||||||

|

from docx.shared import RGBColor, Pt,Inches,Cm

|

||||||

|

from docx.enum.text import WD_PARAGRAPH_ALIGNMENT

|

||||||

|

from docx.oxml.ns import qn

|

||||||

|

|

||||||

|

# 新建文档(Datawhale)

|

||||||

|

doc_1 = Document()

|

||||||

|

|

||||||

|

# 字体设置(全局)

|

||||||

|

'''只更改font.name是不够的,还需要调用._element.rPr.rFonts的set()方法。'''

|

||||||

|

|

||||||

|

doc_1.styles['Normal'].font.name = u'宋体'

|

||||||

|

doc_1.styles['Normal']._element.rPr.rFonts.set(qn('w:eastAsia'), u'宋体')

|

||||||

|

|

||||||

|

# 添加标题(0相当于文章的题目,默认级别是1,级别范围为0-9,0时候自动带下划线)

|

||||||

|

heading_1 = doc_1.add_heading('周杰伦',level = 0)

|

||||||

|

heading_1.alignment = WD_PARAGRAPH_ALIGNMENT.CENTER #居中对齐,默认居左对齐

|

||||||

|

|

||||||

|

# 新增段落

|

||||||

|

paragraph_1 = doc_1.add_paragraph()

|

||||||

|

'''

|

||||||

|

设置段落格式:首行缩进0.75cm,居左,段后距离1.0英寸,1.5倍行距。

|

||||||

|

'''

|

||||||

|

paragraph_1.paragraph_format.first_line_indent = Cm(0.75)

|

||||||

|

paragraph_1.paragraph_format.alignment = WD_PARAGRAPH_ALIGNMENT.LEFT

|

||||||

|

paragraph_1.paragraph_format.space_after = Inches(1.0)

|

||||||

|

paragraph_1.paragraph_format.line_spacing = 1.5

|

||||||

|

|

||||||

|

text = '中国台湾华语流行歌手、' \

|

||||||

|

'音乐创作家、作曲家、作词人、' \

|

||||||

|

'制作人、杰威尔音乐公司老板之一、导演。' \

|

||||||

|

'近年涉足电影行业。周杰伦是2000年后亚洲流行乐坛最具革命性与指标' \

|

||||||

|

'性的创作歌手,有“亚洲流行天王”之称。他突破原有亚洲音乐的主题、形' \

|

||||||

|

'式,融合多元的音乐素材,创造出多变的歌曲风格,尤以融合中西式曲风的嘻哈' \

|

||||||

|

'或节奏蓝调最为著名,可说是开创华语流行音乐“中国风”的先声。周杰伦的' \

|

||||||

|

'出现打破了亚洲流行乐坛长年停滞不前的局面,为亚洲流行乐坛翻开了新的一页!'

|

||||||

|

|

||||||

|

r_1 = paragraph_1.add_run(text)

|

||||||

|

r_1.font.size =Pt(10) #字号

|

||||||

|

r_1.font.bold =True #加粗

|

||||||

|

r_1.font.color.rgb =RGBColor(255,0,0) #颜色

|

||||||

|

|

||||||

|

# 保存文件(当前目录下)

|

||||||

|

doc_1.save('周杰伦.docx')

|

||||||

|

```

|

||||||

|

通过上例我们可以看到,最小的操作对象为文字块,通过run的指定进行操作。比如字号,颜色等;而再上一个层级--段落是的格式是通过paragraph_format进行设置;

|

||||||

|

|

||||||

|

#### (2)字体设置

|

||||||

|

|

||||||

|

通过(1),同学们已经注意到,字体的设置是全局变量。如果我想在不同的部分进行不同字体的设置,那该怎么办呢?这就需要在应用前操作设置一下。

|

||||||

|

|

||||||

|

```python

|

||||||

|

'''字体设置1.py'''

|

||||||

|

#导入库

|

||||||

|

from docx import Document

|

||||||

|

from docx.oxml.ns import qn

|

||||||

|

from docx.enum.style import WD_STYLE_TYPE

|

||||||

|

|

||||||

|

document = Document() # 新建docx文档

|

||||||

|

|

||||||

|

# 设置宋体字样式

|

||||||

|

style_font = document.styles.add_style('宋体', WD_STYLE_TYPE.CHARACTER)

|

||||||

|

style_font.font.name = '宋体'

|

||||||

|

document.styles['宋体']._element.rPr.rFonts.set(qn('w:eastAsia'), u'宋体')

|

||||||

|

|

||||||

|

# 设置楷体字样式

|

||||||

|

style_font = document.styles.add_style('楷体', WD_STYLE_TYPE.CHARACTER)

|

||||||

|

style_font.font.name = '楷体'

|

||||||

|

document.styles['楷体']._element.rPr.rFonts.set(qn('w:eastAsia'), u'楷体') # 将段落中的所有字体

|

||||||

|

|

||||||

|

# 设置华文中宋字样式

|

||||||

|

style_font = document.styles.add_style('华文中宋', WD_STYLE_TYPE.CHARACTER)

|

||||||

|

style_font.font.name = '华文中宋'

|

||||||

|

document.styles['华文中宋']._element.rPr.rFonts.set(qn('w:eastAsia'), u'华文中宋')

|

||||||

|

|

||||||

|

paragraph1 = document.add_paragraph() # 添加段落

|

||||||

|

run = paragraph1.add_run(u'aBCDefg这是中文', style='宋体') # 设置宋体样式

|

||||||

|

|

||||||

|

font = run.font #设置字体

|

||||||

|

font.name = 'Cambira' # 设置西文字体

|

||||||

|

paragraph1.add_run(u'aBCDefg这是中文', style='楷体').font.name = 'Cambira'

|

||||||

|

paragraph1.add_run(u'aBCDefg这是中文', style='华文中宋').font.name = 'Cambira'

|

||||||

|

|

||||||

|

document.save('字体设置1.docx')

|

||||||

|

```

|

||||||

|

|

||||||

|

```python

|

||||||

|

'''字体设置2.py'''

|

||||||

|

#导入库

|

||||||

|

from docx import Document

|

||||||

|

from docx.oxml.ns import qn

|

||||||

|

from docx.enum.style import WD_STYLE_TYPE

|

||||||

|

|

||||||

|

#定义字体设置函数

|

||||||

|

def font_setting(doc,text,font_cn):

|

||||||

|

style_add = doc.styles.add_style(font_cn, WD_STYLE_TYPE.CHARACTER)

|

||||||

|

style_add.font.name = font_cn

|

||||||

|

doc.styles[font_cn]._element.rPr.rFonts.set(qn('w:eastAsia'), font_cn)

|

||||||

|

par = doc.add_paragraph()

|

||||||

|

text = par.add_run(text, style=font_cn)

|

||||||

|

|

||||||

|

doc = Document()

|

||||||

|

a = '小朋友 你是否有很多问号'

|

||||||

|

b = '为什么 别人在那看漫画'

|

||||||

|

c = '我却在学画画 对着钢琴说话'

|

||||||

|

|

||||||

|

font_setting(doc,a,'宋体')

|

||||||

|

font_setting(doc,b,'华文中宋')

|

||||||

|

font_setting(doc,c,'黑体')

|

||||||

|

|

||||||

|

doc.save('字体设置2.docx')

|

||||||

|

|

||||||

|

```

|

||||||

|

|

||||||

|

我们很容易地看出来,字体设置1.py与字体设置2.py的区别在于是否为同一段落,同时字体设置2.py中自定义了一个函数。同学们可以在实际工作中看具体场景进行选择。

|

||||||

|

|

||||||

|

#### (3) 插入图片与表格

|

||||||

|

|

||||||

|

```python

|

||||||

|

#导入库

|

||||||

|

from docx import Document

|

||||||

|

from docx.shared import Inches

|

||||||

|

|

||||||

|

#打开文档

|

||||||

|

doc_1 = Document('周杰伦.docx') #上面脚本存储的文档

|

||||||

|

#新增图片

|

||||||

|

doc_1.add_picture('周杰伦.jpg',width=Inches(1.0), height=Inches(1.0))

|

||||||

|

|

||||||

|

# 创建3行1列表格

|

||||||

|

table1 = doc_1.add_table(rows=2, cols=1)

|

||||||

|

table1.style='Medium Grid 1 Accent 1' #表格样式很多种,如,Light Shading Accent 1等

|

||||||

|

|

||||||

|

# 修改第2行第3列单元格的内容为营口

|

||||||

|

table1.cell(0, 0).text = '营口'

|

||||||

|

# 修改第3行第4列单元格的内容为人民

|

||||||

|

table1.rows[1].cells[0].text = '人民'

|

||||||

|

|

||||||

|

# 在表格底部新增一行

|

||||||

|

row_cells = table1.add_row().cells

|

||||||

|

# 新增行的第一列添加内容

|

||||||

|

row_cells[0].text = '加油'

|

||||||

|

|

||||||

|

doc_1.save('周杰伦为营口加油.docx')

|

||||||

|

|

||||||

|

```

|

||||||

|

|

||||||

|

#### (4)设置页眉页脚

|

||||||

|

|

||||||

|

在python-docx包中则要使用节(section)中的页眉(header)和页脚(footer)对象来具体设置。

|

||||||

|

|

||||||

|

```python

|

||||||

|

from docx import Document

|

||||||

|

from docx.enum.text import WD_PARAGRAPH_ALIGNMENT

|

||||||

|

|

||||||

|

document = Document() # 新建文档

|

||||||

|

|

||||||

|

header = document.sections[0].header # 获取第一个节的页眉

|

||||||

|

print('页眉中默认段落数:', len(header.paragraphs))

|

||||||

|

paragraph = header.paragraphs[0] # 获取页眉的第一个段落

|

||||||

|

paragraph.add_run('这是第一节的页眉') # 添加页面内容

|

||||||

|

footer = document.sections[0].footer # 获取第一个节的页脚

|

||||||

|

paragraph = footer.paragraphs[0] # 获取页脚的第一个段落

|

||||||

|

paragraph.add_run('这是第一节的页脚') # 添加页脚内容

|

||||||

|

|

||||||

|

|

||||||

|

'''在docx文档中又添加了2个节,共计3个节,页面和页脚会显示了“与上一节相同”。

|

||||||

|

如果不使用上一节的内容和样式要将header.is_linked_to_previous的属性或footer.is_linked_to_previous的属性设置为False,

|

||||||

|

用于解除“链接上一节页眉”或者“链接上一节页脚”。'''

|

||||||

|

document.add_section() # 添加一个新的节

|

||||||

|

document.add_section() # 添加第3个节

|

||||||

|

header = document.sections[1].header # 获取第2个节的页眉

|

||||||

|

header.is_linked_to_previous = False # 不使用上节内容和样式

|

||||||

|

|

||||||

|

#对齐设置

|

||||||

|

header = document.sections[1].header # 获取第2个节的页眉

|

||||||

|

header.is_linked_to_previous = False # 不使用上节内容和样式

|

||||||

|

paragraph = header.paragraphs[0]

|

||||||

|

paragraph.add_run('这是第二节的页眉')

|

||||||

|

paragraph.alignment = WD_PARAGRAPH_ALIGNMENT.CENTER # 设置页眉居中对齐

|

||||||

|

document.sections[1].footer.is_linked_to_previous = False

|

||||||

|

footer.paragraphs[0].add_run('这是第二节的页脚') # 添加第2节页脚内容

|

||||||

|

footer.paragraphs[0].alignment = WD_PARAGRAPH_ALIGNMENT.CENTER # 设置第2节页脚居中对齐

|

||||||

|

header = document.sections[2].header # 获取第3个节的页眉

|

||||||

|

header.is_linked_to_previous = False # 不使用上节的内容和样式

|

||||||

|

paragraph = header.paragraphs[0] # 获取页眉中的段落

|

||||||

|

paragraph.add_run('这是第三节的页眉')

|

||||||

|

paragraph.alignment = WD_PARAGRAPH_ALIGNMENT.RIGHT # 设置页眉右对齐

|

||||||

|

document.sections[2].footer.is_linked_to_previous = False

|

||||||

|

footer.paragraphs[0].add_run('这是第三节的页脚') # 添加第3节页脚内容

|

||||||

|

footer.paragraphs[0].alignment = WD_PARAGRAPH_ALIGNMENT.RIGHT # 设置第3节页脚右对齐

|

||||||

|

document.save('页眉页脚1.docx') # 保存文档

|

||||||

|

```

|

||||||

|

|

||||||

|

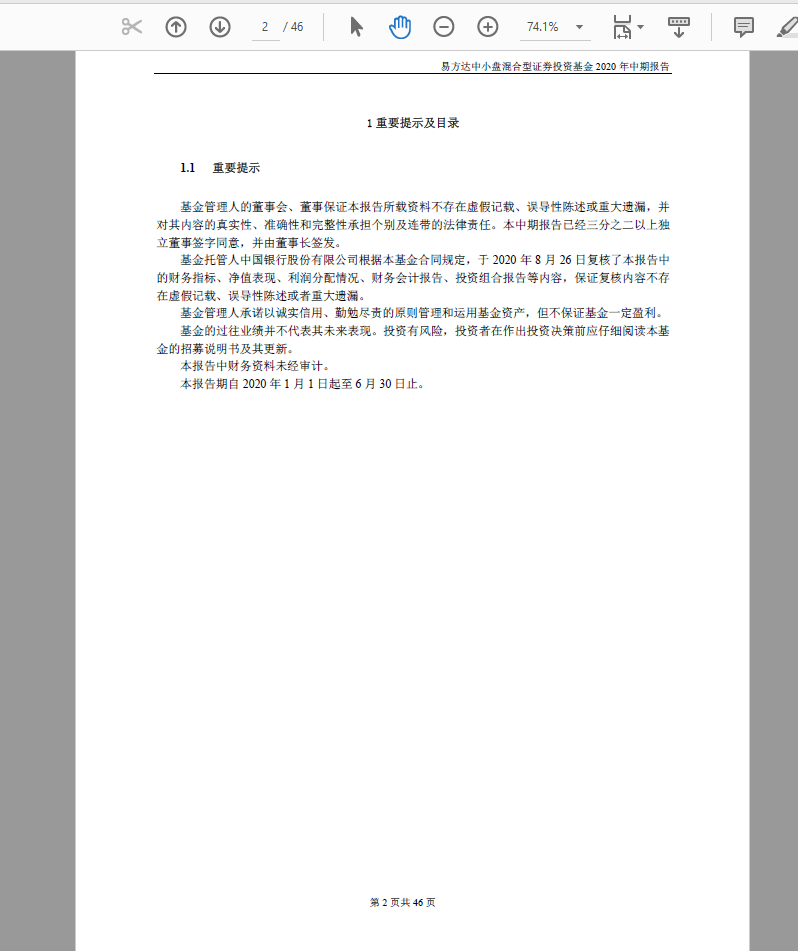

结果如下:

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

#### (5)代码延伸

|

||||||

|

|

||||||

|

```python

|

||||||

|

'''对齐设置'''

|

||||||

|

from docx.enum.text import WD_ALIGN_PARAGRAPH

|

||||||

|

#LEFT: 左对齐

|

||||||

|

#CENTER: 文字居中

|

||||||

|

#RIGHT: 右对齐

|

||||||

|

#JUSTIFY: 文本两端对齐

|

||||||

|

|

||||||

|

'''设置段落行距'''

|

||||||

|

from docx.shared import Length

|

||||||

|

# SINGLE :单倍行距(默认)

|

||||||

|

#ONE_POINT_FIVE : 1.5倍行距

|

||||||

|

# DOUBLE2 : 倍行距

|

||||||

|

#AT_LEAST : 最小值

|

||||||

|

#EXACTLY:固定值

|

||||||

|

# MULTIPLE : 多倍行距

|

||||||

|

|

||||||

|

paragraph.line_spacing_rule = WD_LINE_SPACING.EXACTLY #固定值

|

||||||

|

paragraph_format.line_spacing = Pt(18) # 固定值18磅

|

||||||

|

paragraph.line_spacing_rule = WD_LINE_SPACING.MULTIPLE #多倍行距

|

||||||

|

paragraph_format.line_spacing = 1.75 # 1.75倍行间距

|

||||||

|

|

||||||

|

'''设置字体属性'''

|

||||||

|

from docx.shared import RGBColor,Pt

|

||||||

|

#all_caps:全部大写字母

|

||||||

|

#bold:加粗

|

||||||

|

#color:字体颜色

|

||||||

|

|

||||||

|

#double_strike:双删除线

|

||||||

|

#hidden : 隐藏

|

||||||

|

#imprint : 印记

|

||||||

|

#italic : 斜体

|

||||||

|

#name :字体

|

||||||

|

#shadow :阴影

|

||||||

|

#strike : 删除线

|

||||||

|

#subscript :下标

|

||||||

|

#superscript :上标

|

||||||

|

#underline :下划线

|

||||||

|

```

|

||||||

|

|

||||||

|

## 三、项目实践

|

||||||

|

|

||||||

|

### 一、需求

|

||||||

|

|

||||||

|

> 你是公司的行政人员,对合作伙伴进行邀请,参加公司的会议;

|

||||||

|

>

|

||||||

|

> 参会人名单如下:

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

拟定的邀请函样式如下:

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

**根据参会人名单,利用python批量生成邀请函。**

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

### 二、需求分析